关于参数优化

http://www.cnblogs.com/sandy-t/p/6863918.html

模型一般有两种参数:一种是从数据中训练拟合出来的,一种是无法从数据中估计,只能靠人的经验进行指定,后一类参数就叫超参数hyper parameter.

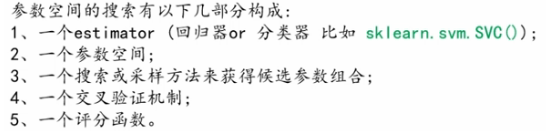

支持向量机里的C,Kernel,gama,朴素贝叶斯里的alpha等,在学习其模型的设计中,我们要搜索超参数空间为学习器模型找到最合理的超参数,可以通过以下方法获得学习器模型的参数列表和当前取值:estimator.get_params()

sklearn 提供了两种通用的参数优化方法:网络搜索和随机采样,

- 网格搜索交叉验证(GridSearchCV):以穷举的方式遍历所有可能的参数组合 ;性能好点。

- 随机采样交叉验证(RandomizedSearchCV):依据某种分布对参数空间采样,随机的得到一些候选参数组合方案;性能差点,但速度快

sklearn.model_selection:GridSearchCV,

RandomizedSearchCV,

ParameterGrid,

ParameterSampler,

fit_grid_point

超参数空间的搜索技巧

- 技巧一,指定一个合适的目标测度对模型进行估计

默认情况下,参数搜索使用estimator的score函数来评估模型在某种参数配置下的性能:

分类器对应于 sklearn.metrics.accuracy_score

回归器对应于sklearn.metrics.r2_score

但是在某些应用中,其他的评分函数获取更加的合适。(比如在非平衡的分类问题中,准确率sccuracy_score通常不管用。这时,可以通过参数scoring来指定GridSearchCV类或者RandomizedSearchCV类内 部用我们自定义的评分函数)

- 技巧二、使用SKlearn的PipeLine将estimators和他们的参数空间组合起来

- 技巧三、合理划分数据集:开发集(用于GridSearchCV)+测试集(Test)使用model_selection.train_test_split()函数来搞定!

- 技巧四、并行化:(GridSearchCV)和(RandomizedSearchCV)在参数节点的计算上可以做到并行计算,这个通过参数”n_jobs“来指定。

- 技巧五、提高在某些参数节点上发生错误时的鲁棒性:在出错节点上只是提示警告。可以通过设置参数error_score=0(or=np.NaN)来搞定!