LSTM (long-short term Memory)

understand LSTM http://colah.github.io/posts/2015-08-Understanding-LSTMs/

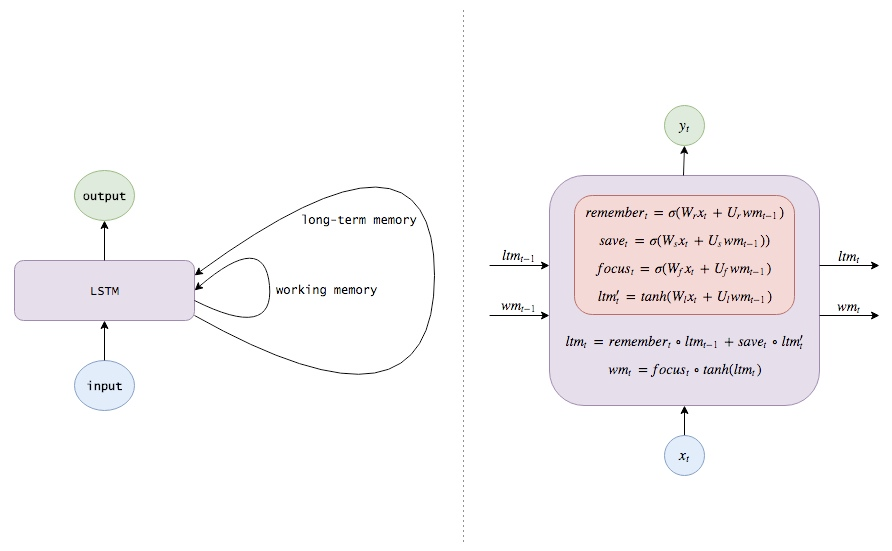

LSTM 是RNN的一种变体,目的是希望循环神经网络可以将过去时刻发生的状态信息传递给当前时刻的计算中。

但普通的RNN结构却难以传递相隔较远的信息。

LSTM改进:

- 增加遗忘机制。例如当一个场景结束是,模型应该重置场景的相关信息,例如位置、时间等。而一个角色死亡,模型也应该记住这一点。所以,我们希望模型学会一个独立的忘记/记忆机制,当有新的输入时,模型应该知道哪些信息应该丢掉。

增加保存机制。当模型看到一副新图的时候,需要学会其中是否有值得使用和保存的信息。

所以当有一个新的输入时,模型首先忘掉哪些用不上的长期记忆信息,然后学习新输入有什么值得使用的信息,然后存入长期记忆中。

把长期记忆聚焦到工作记忆中。最后,模型需要学会长期记忆的哪些部分立即能派上用场。不要一直使用完整的长期记忆,而要知道哪些部分是重点。

RNN 与 LSTM 对比

RNN会以相当不受控制的方式在每个时间步长内重写自己的记忆。而LSTM则会以非常精确的方式改变记忆,应用专门的学习机制来记住、更新、聚焦于信息。这有助于在更长的时期内跟踪信息。

LSTM 数学模型

训练